Hadoop Part 1 - 模板机制作

文章导航

Hadoop Part 1 - 模板机制作

【版本】

当前版本号v20210423

| 版本 | 修改说明 |

|---|---|

| v20210423 | 修正DNS的地址 |

| v20210415 | 增加步骤66的命令 |

| v20210402 | 修改步骤35,增加修改密码的命令 |

| v20210331 | 修改步骤59,增加source命令 |

| v20210314 | 初始化版本 |

【实验名称】

Hadoop Part 1 - 模板机制作

【实验目的】

- 掌握搭建 CentOS 模板镜像

- 熟练掌握Linux命令(vi、tar、mv等等)的使用

- 掌握VMWare、XShell等客户端的使用

【实验环境】

- 内存:至少4G

- 硬盘:至少空余40G

- 操作系统: 64位 Windows系统。

【实验资源】

- XShell

- CentOS 7.4系统镜像

- VMWare WorkStation Pro

- Hadoop 安装包

下载链接:https://pan.baidu.com/s/1ghde86wcK6pwg1fdSSWg0w

提取码:v3wv

【实验步骤】

安装 VMWare Workstation Pro。过程略。

安装 XShell。过程略。

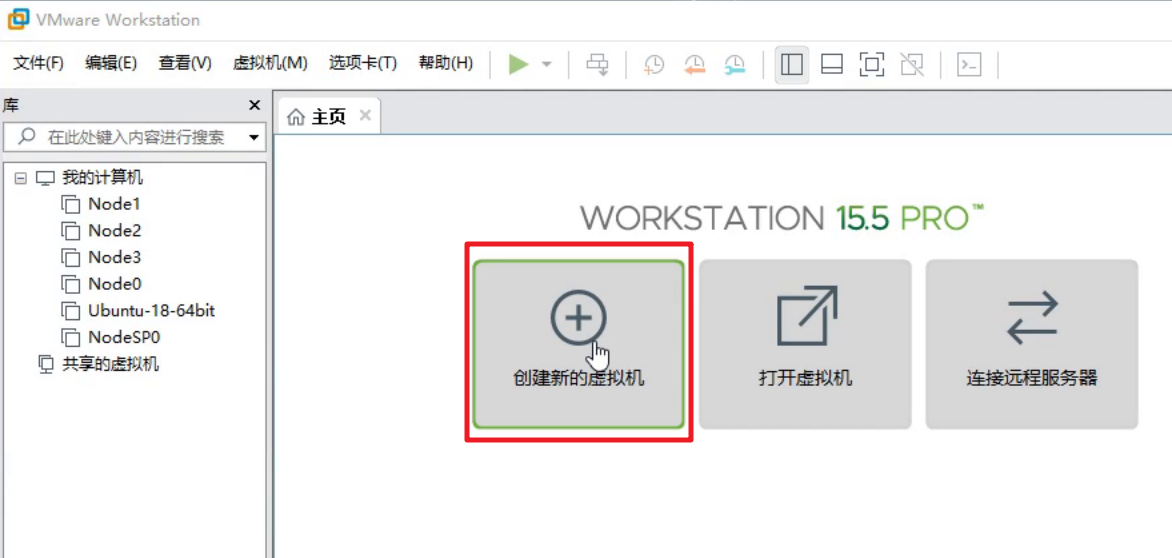

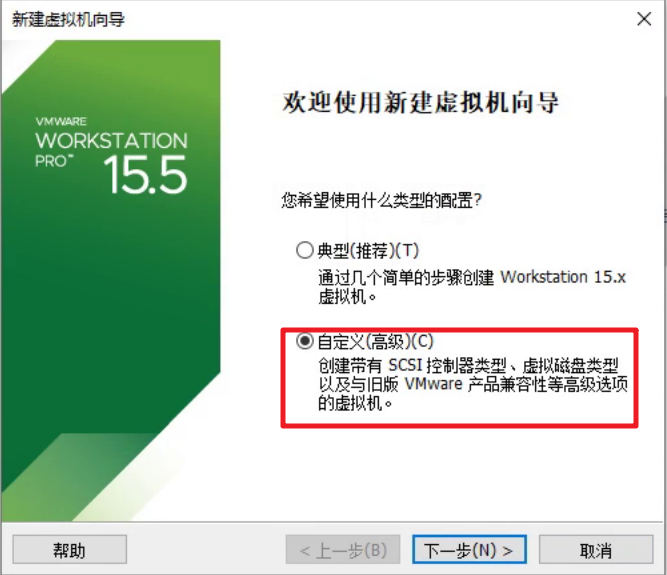

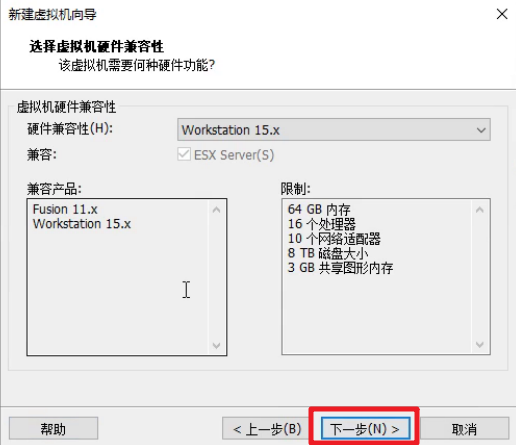

启动VMWare WorkStation Pro,点击“新建新的虚拟机”,开始制作CentOS 模板镜像。

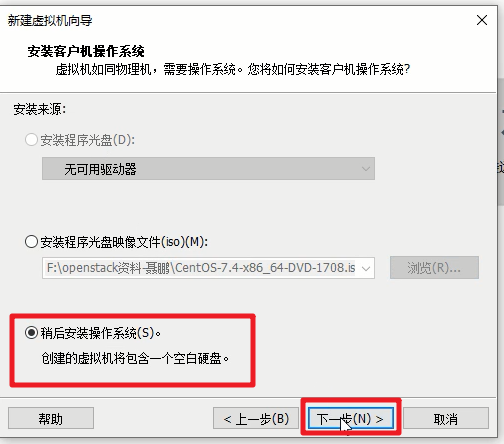

选择稍后安装操作系统。

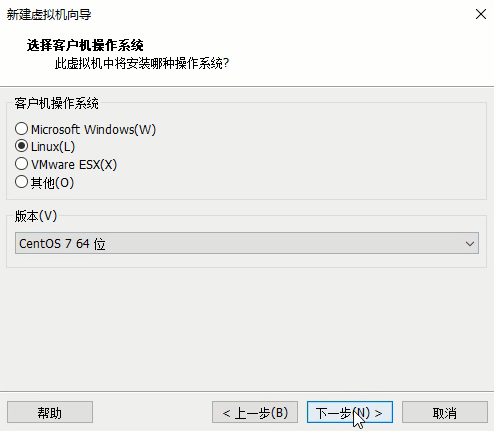

选择Linux系统,版本为

CentOS 7 64位

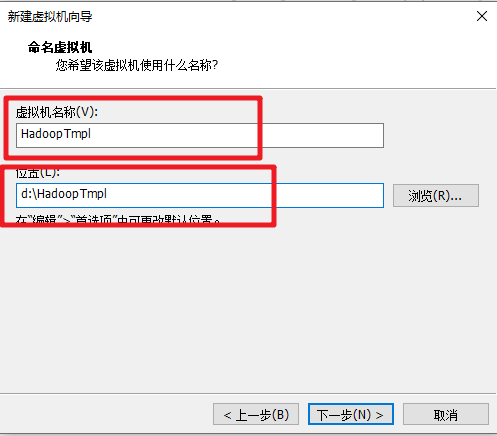

注意此处需要把虚拟机名称命名为

HadoopTmpl+你个人学号后4位(不符合要求会扣分),并选择合适文件目录进行保存。

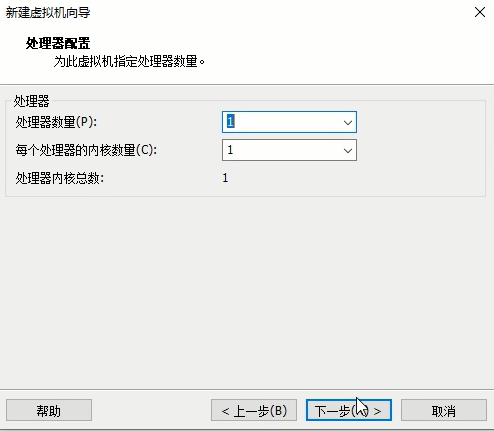

处理器和内核数都设置为1。

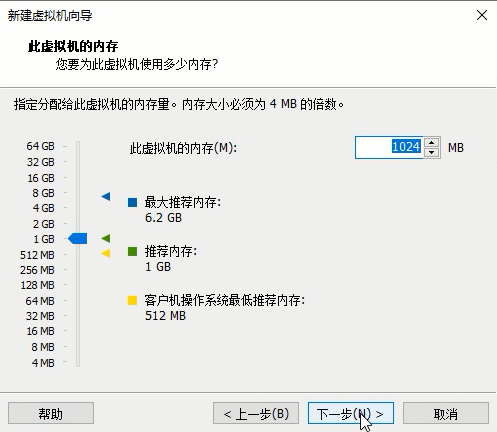

内存设置为1024M。

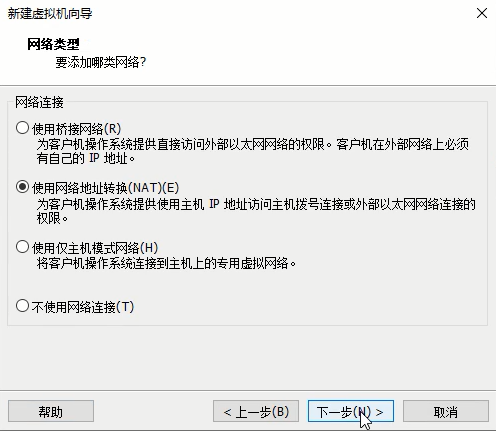

网络连接选择

NAT。

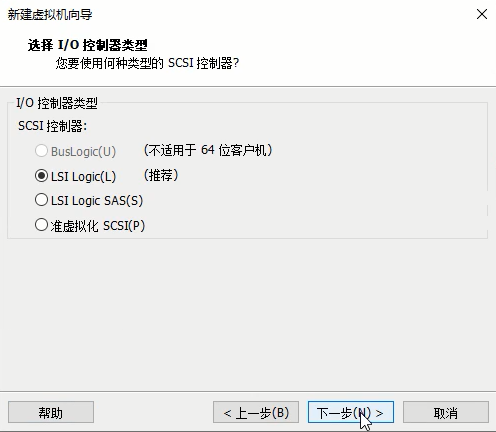

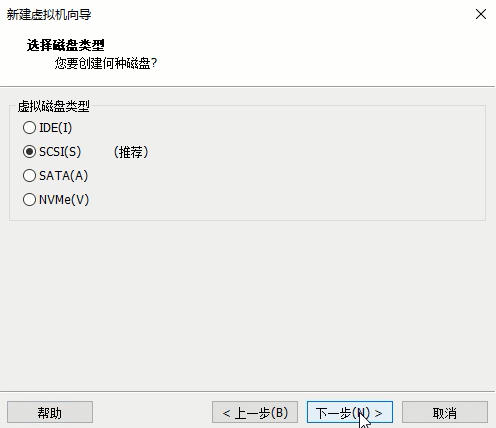

IO控制器和磁盘类型设为默认设置。

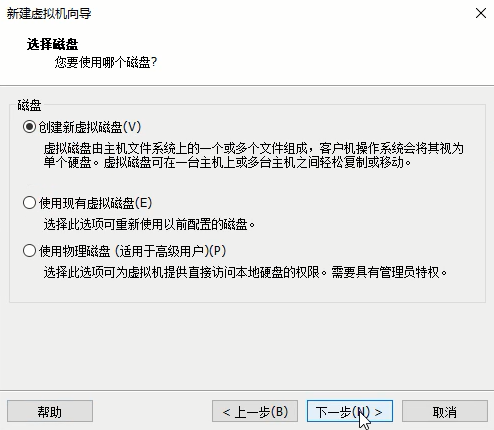

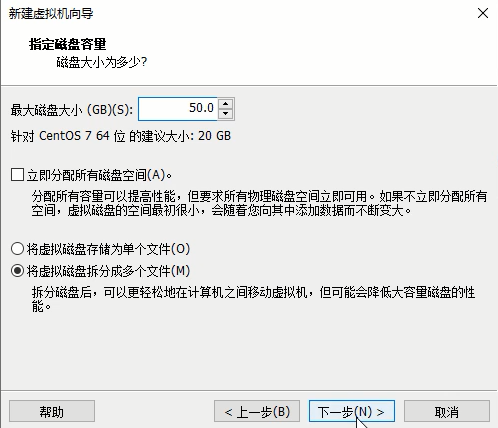

创建新虚拟磁盘,空间可设为50G。

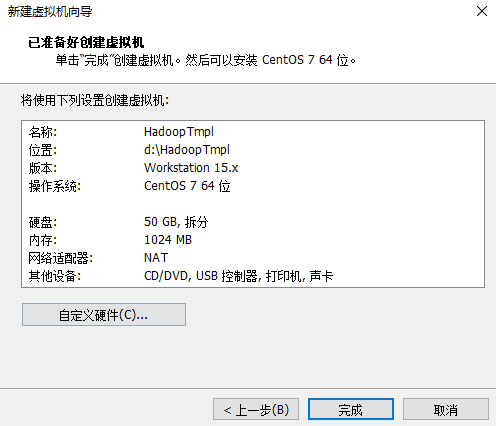

完成虚拟机创建向导。

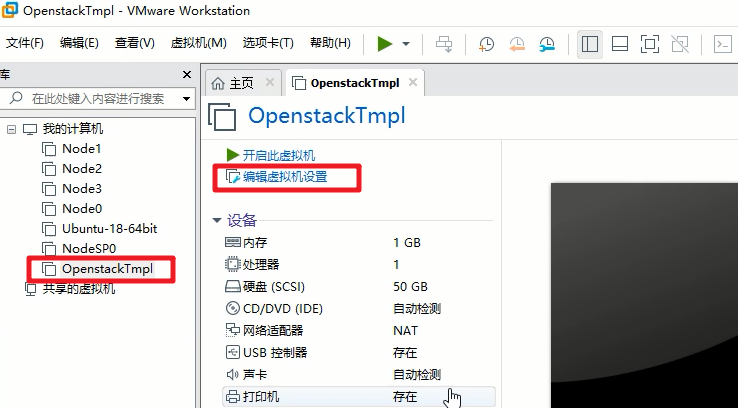

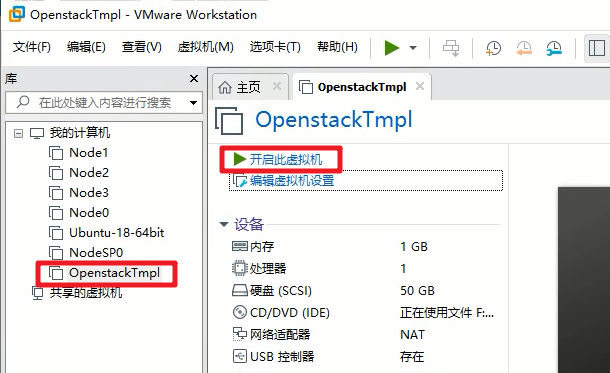

选中刚完成的虚拟机,点击编辑虚拟机设置。

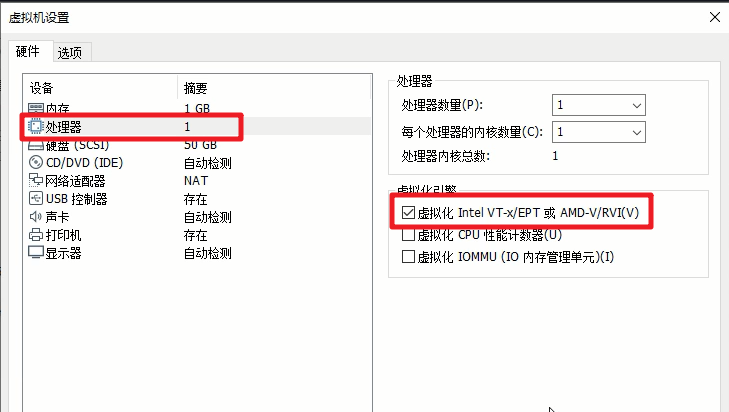

处理器设置勾选

虚拟化Intel VT-x/EPT 或 AMD-V/RVI(V)。

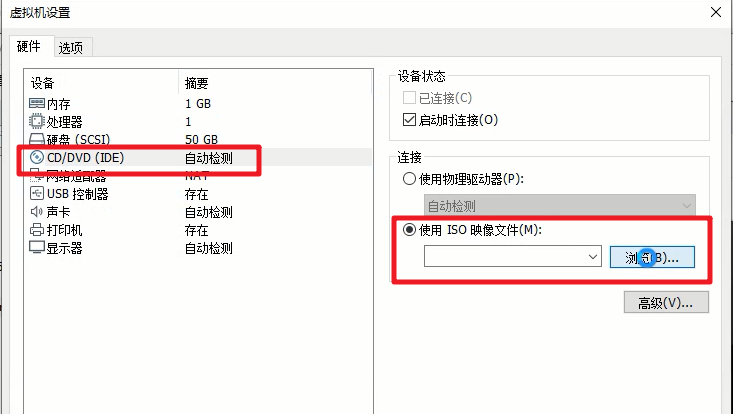

CD/DVD选项加载课程资源提供的CentOS系统安装镜像文件

CentOS-7.4-x86_64-DVD-1708.iso。

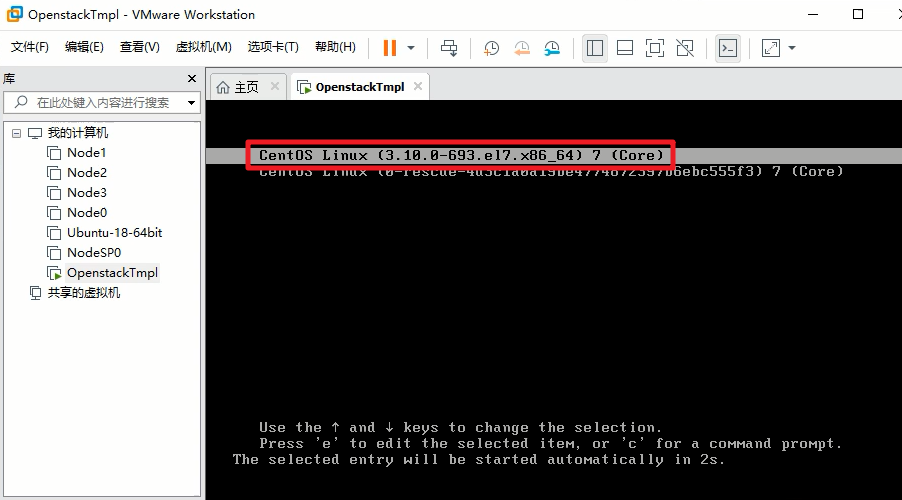

关闭设置窗口,启动模板镜像虚拟机。

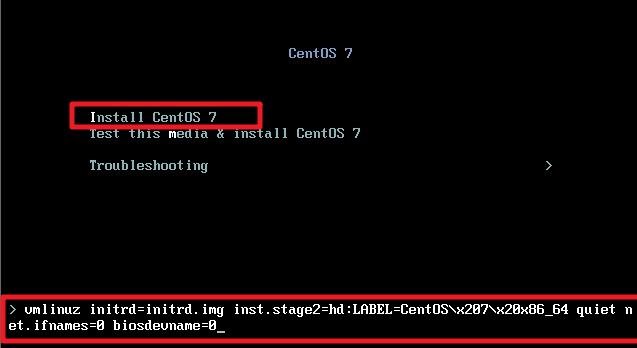

进入CentOS 7 安装界面,按下键盘

Tab键,输入以下代码,这里代码主要是指定网口名称从0(eth0)开始编号。并选择Install CentOS 7。输入的时候注意这行代码中间只有一个空格!

net.ifnames=0 biosdevname=0

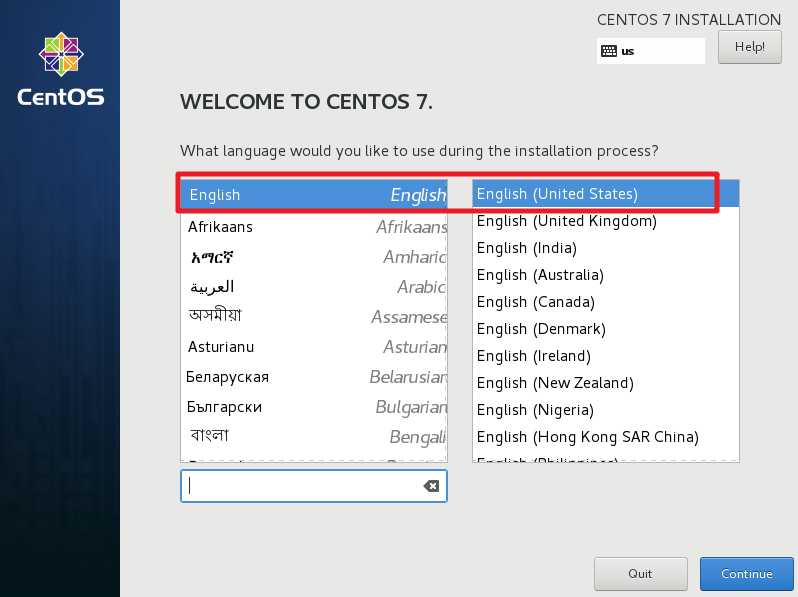

虚拟机安装语言选择默认英语。

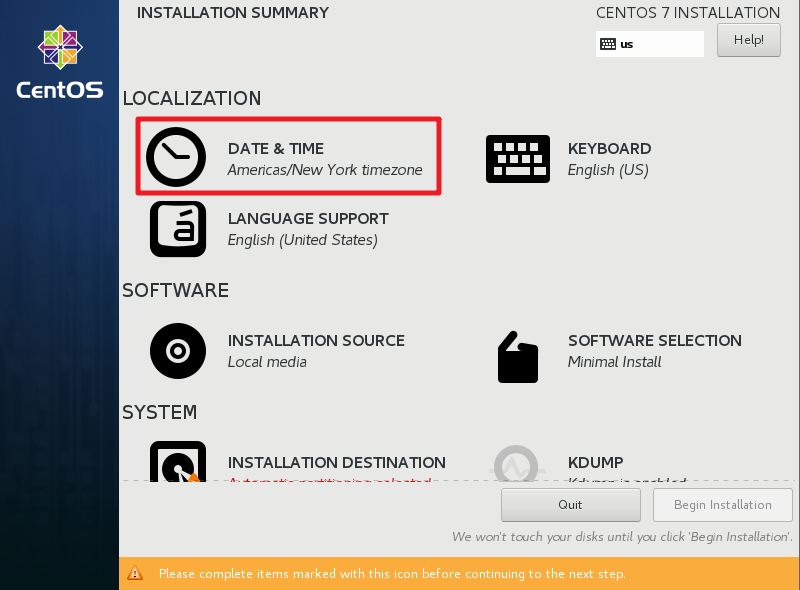

时区选择东8区,注意调整时间为你当前安装的实际时间。

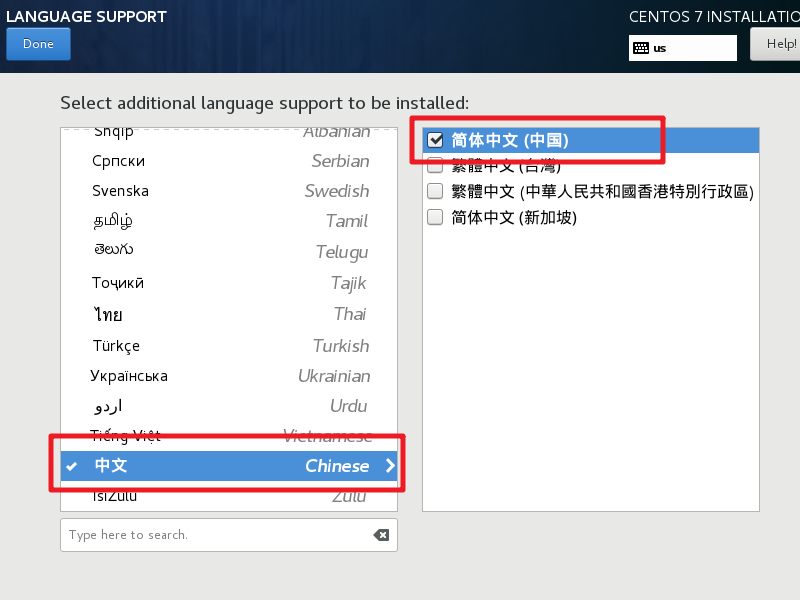

语言支持勾选中文。

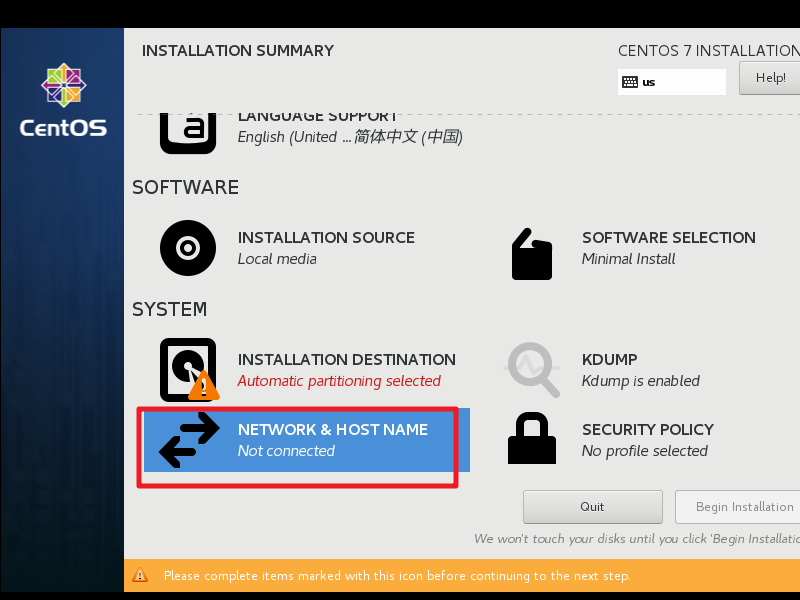

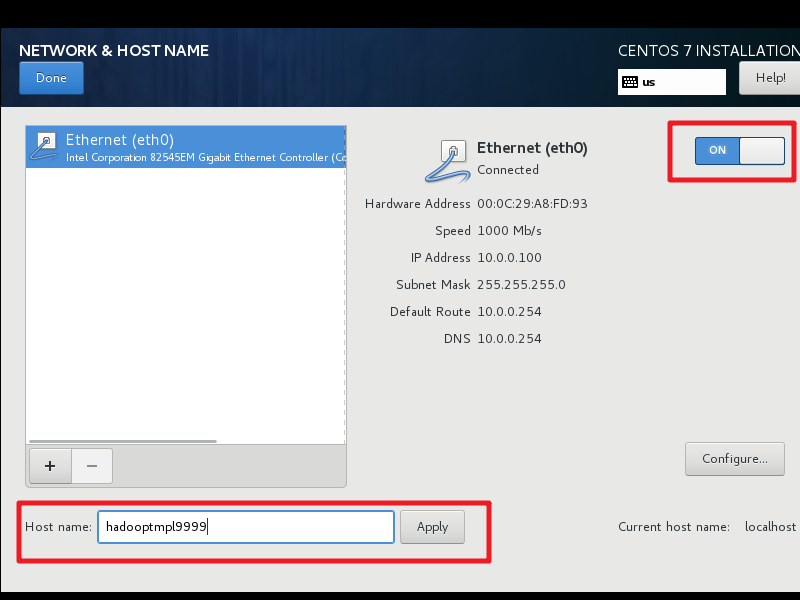

网口设置,启用网口,并设置 Host Name 为

hadooptmpl+你个人学号后4位

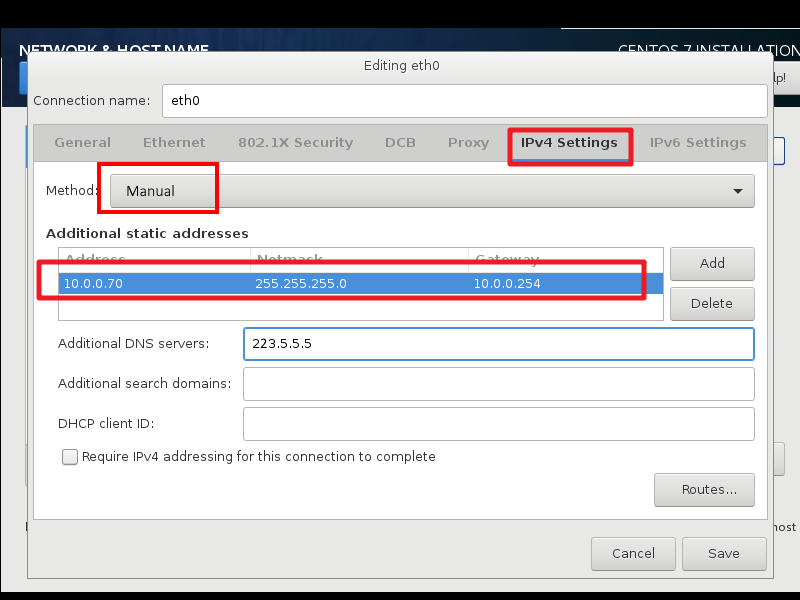

设置网口信息。

地址:10.0.0.70

掩码:24

网关:10.0.0.254

DNS:223.5.5.5

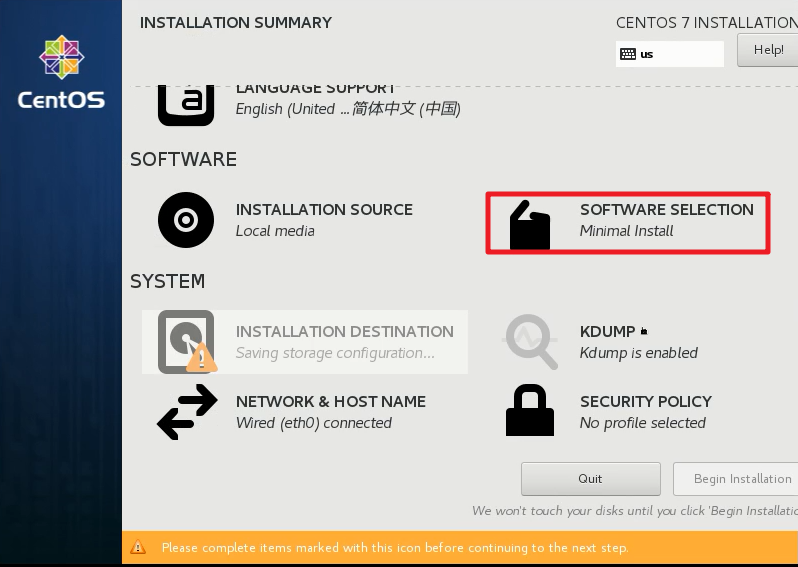

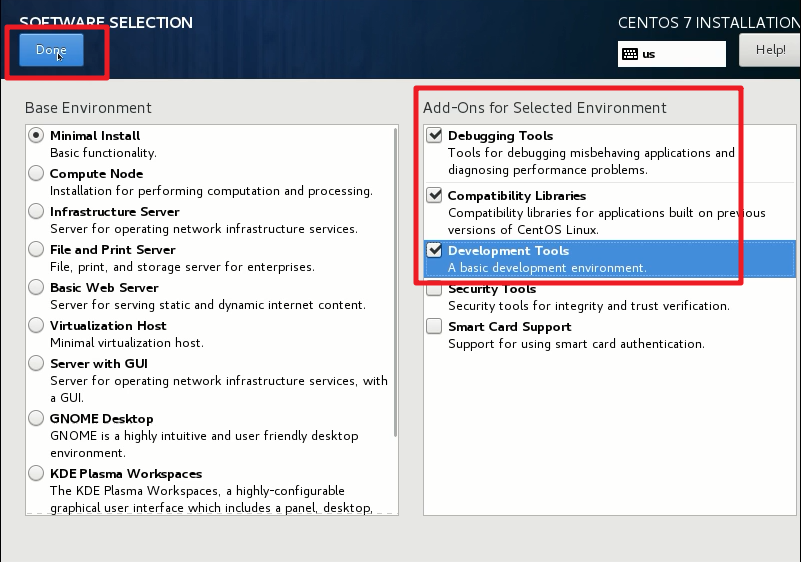

回到主界面,进入软件选择界面,按下图选择安装软件。

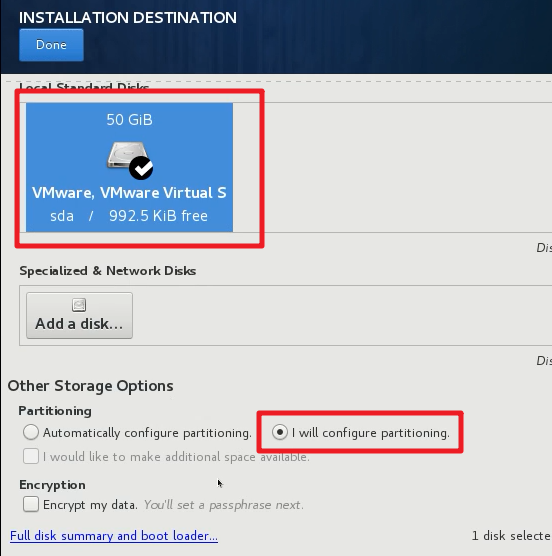

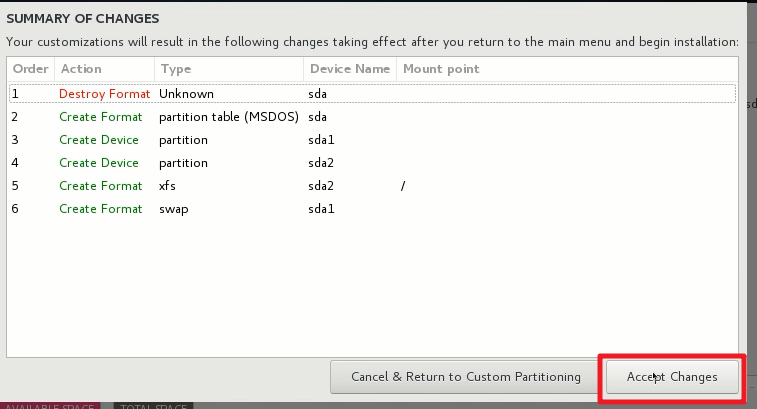

回到主界面,进入系统安装位置菜单。

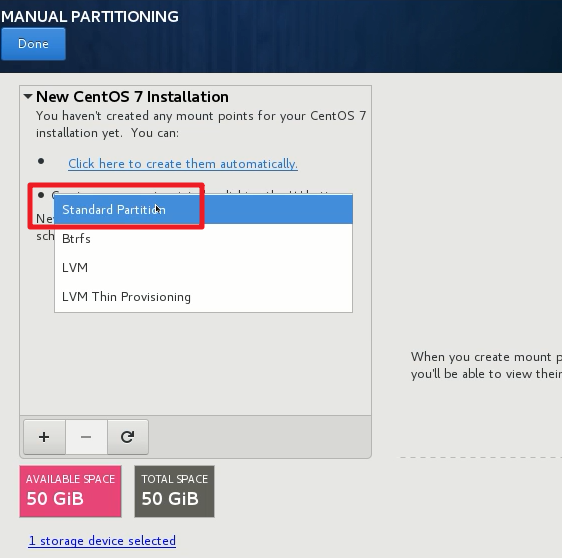

选择手动分区。

选择标准分区格式

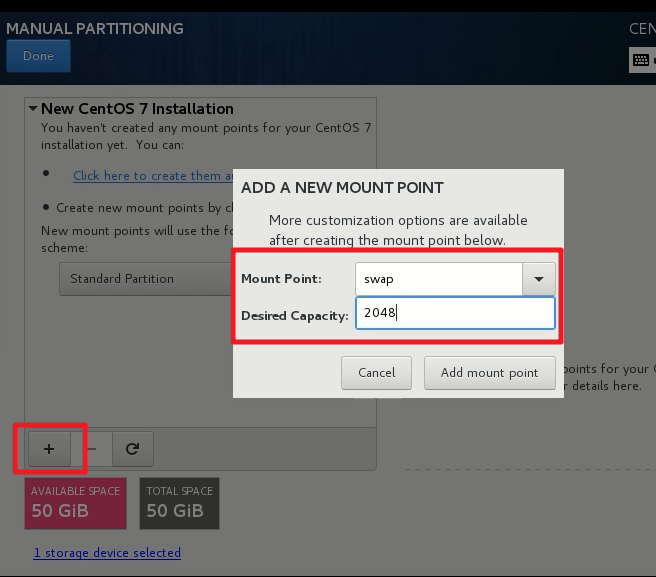

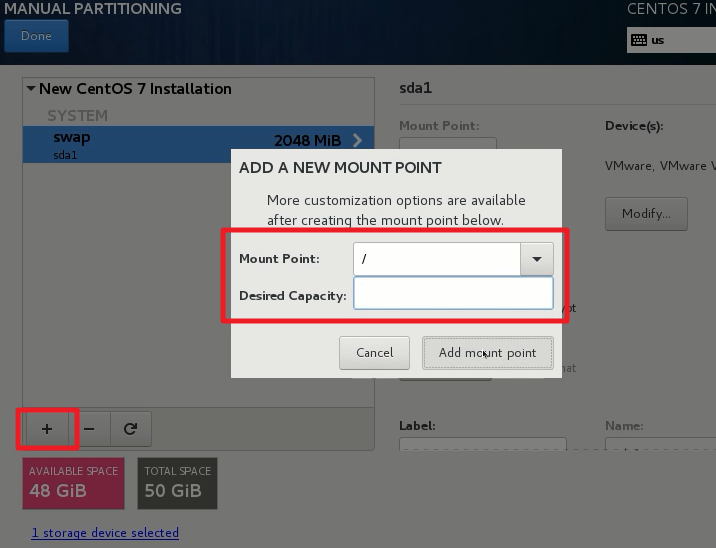

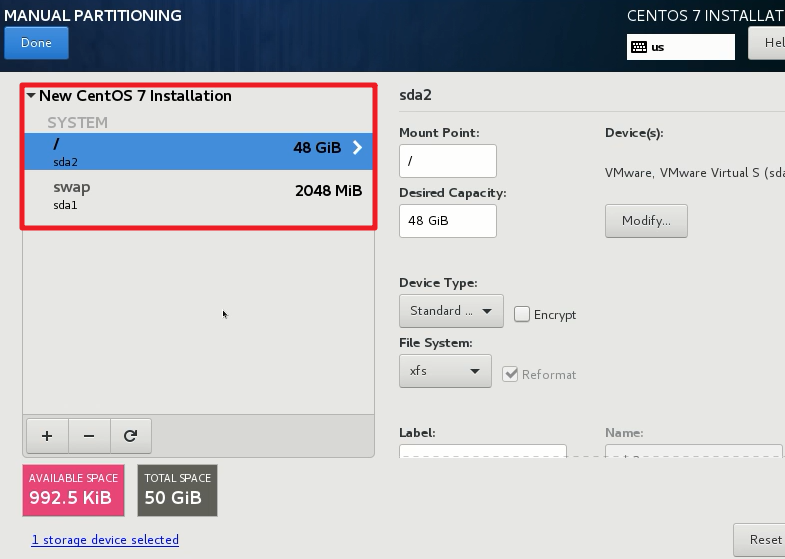

新建2个分区(Partition)

swap分区:2048M

根分区:剩余所有空间

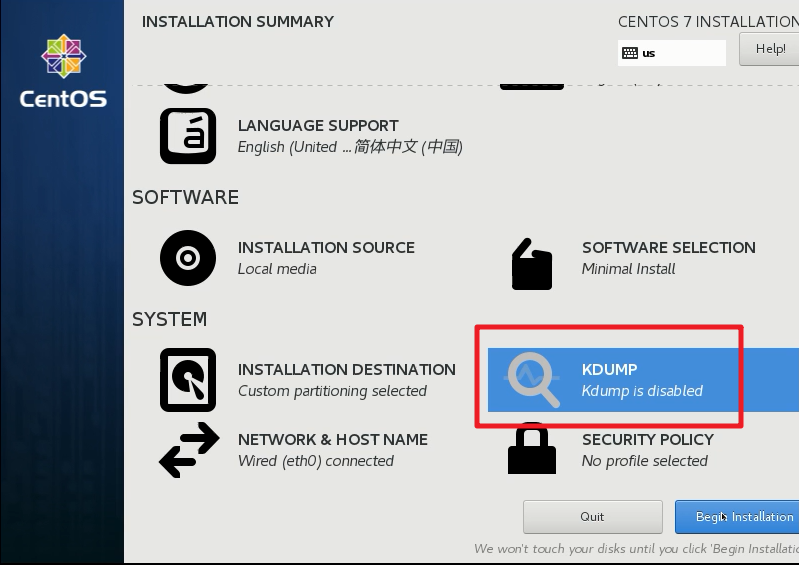

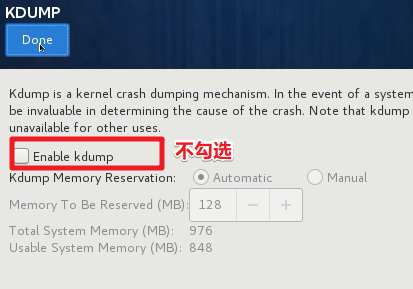

- 禁用KDUMP。

kdump是Linux内核的一个功能,可在发生内核错误时创建核心转储。当被触发时,kdump会导出一个内存映像,该映像可用于调试和确定崩溃的原因。

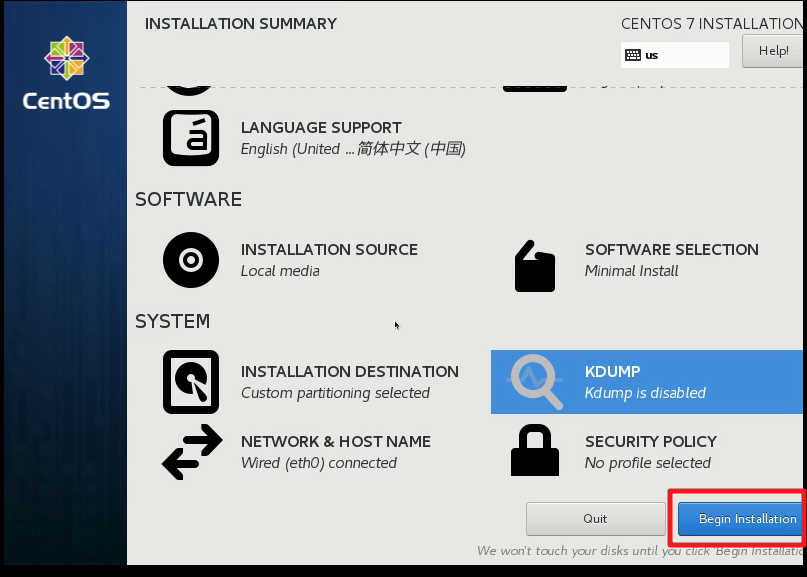

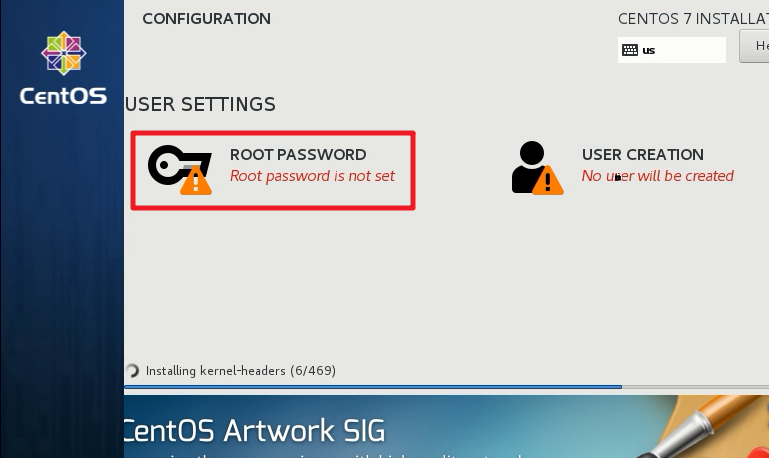

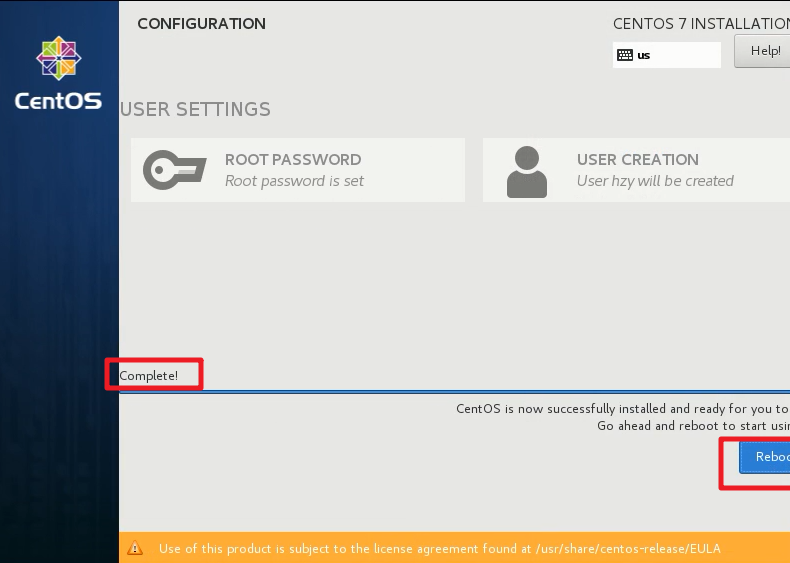

开始安装系统

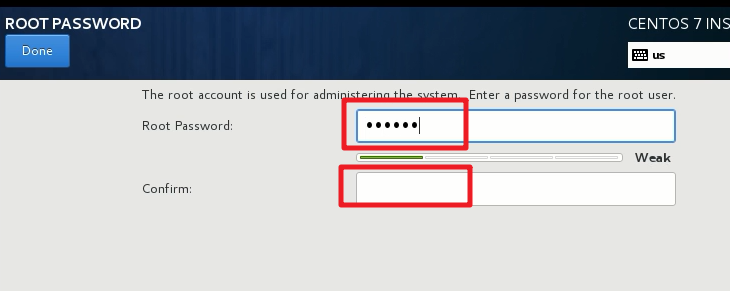

Root密码设置为

123456

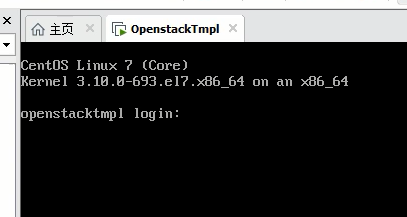

等待系统安装完毕以后,点击重启。

重启以后,尝试使用root账户登录,密码为刚才设置的

123456。

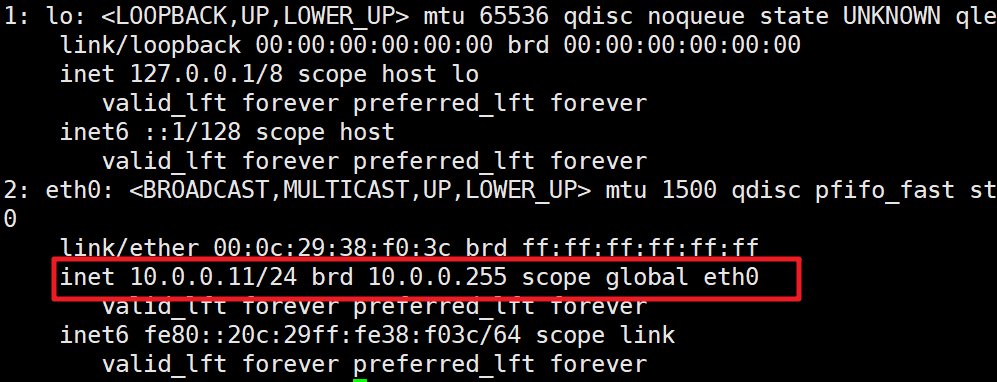

输入以下代码查看 IP,网关等网络设置是否正常显示。

ip a

- 如果eth0端口显示多个IP,可以编辑端口信息,设置为静态IP。

vi /etc/sysconfig/network-scripts/ifcfg-eth0

#修改为静态IP

BOOTPROTO="static"

- 创建一个名为hadoop的用户,加入用户组wheel。

useradd -r hadoop -u 600 -g wheel -m

修改hadoop用户密码,重复输入密码123456

passwd hadoop

- 从root用户切换至hadoop用户。

su hadoop

- 进入hadoop用户默认目录

/home/hadoop。

cd ~

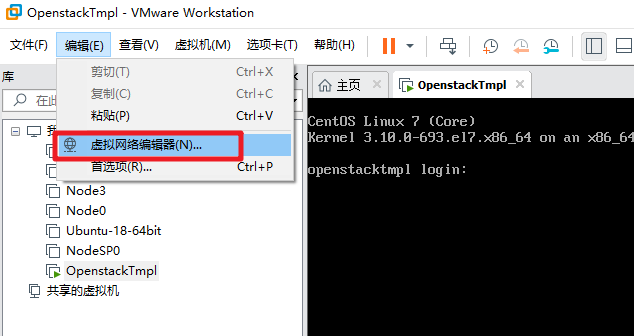

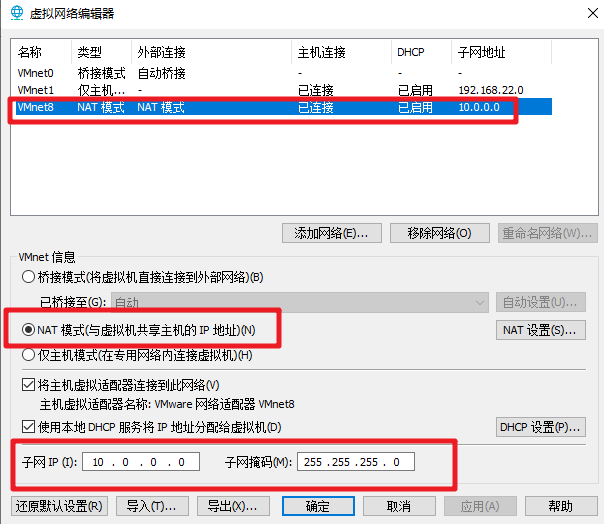

打开VMWare的虚拟网络编辑器,按下图配置网络设置。

进入

NAT设置,设置网关为10.0.0.254

进入

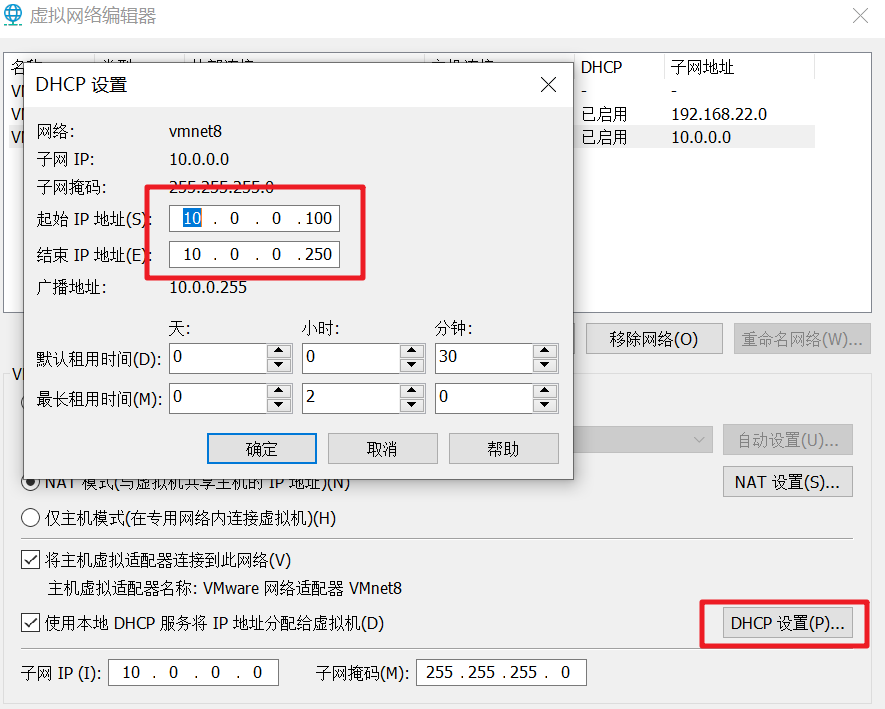

DHCP设置,设置网段为10.0.0.100-10.0.0.250

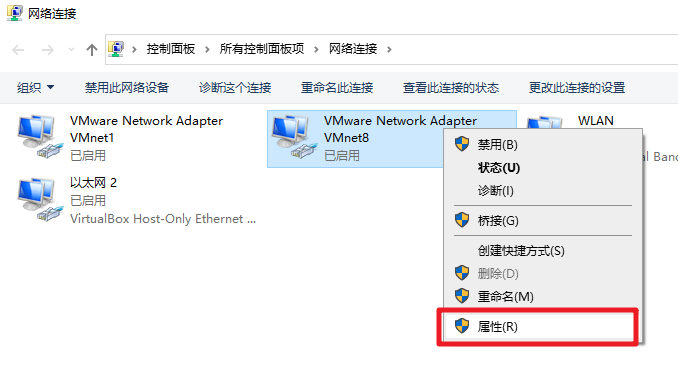

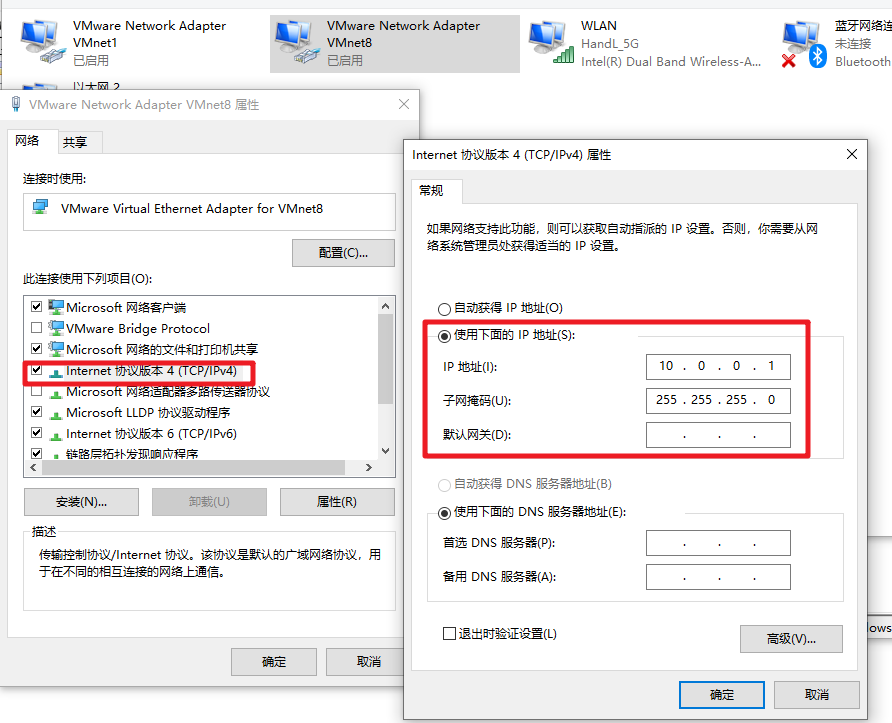

进入当前Windows系统的网卡设置,修改虚拟网卡的配置。

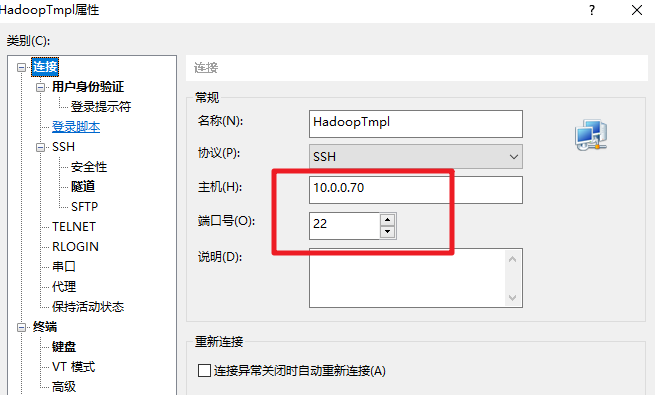

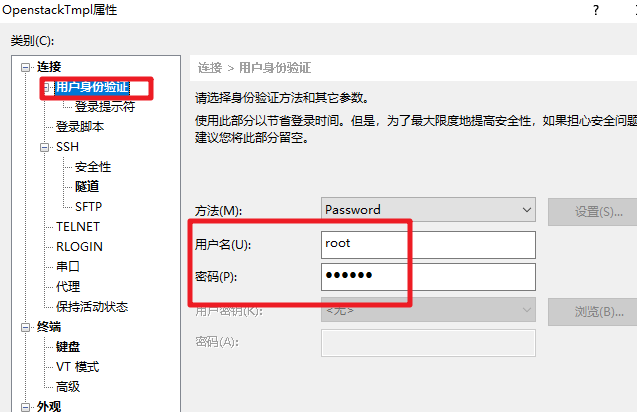

打开XShell,使用 hadoop 用户SSH方式登录虚拟机。

IP:10.0.0.70

端口:22

用户名:hadoop

密码:123456

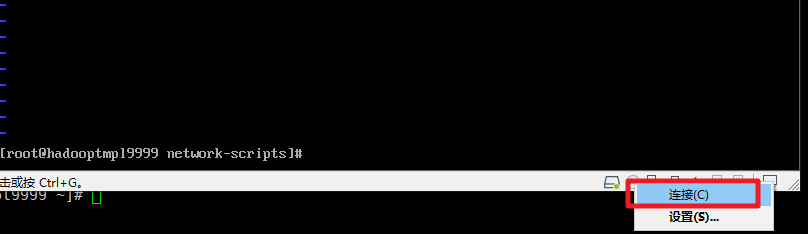

- 使用

su命令,输入root的密码,切换为root用户。

su

- 执行以下命令,关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

- 备份 SELinux 配置文件,并关闭 SELinux。

cp /etc/selinux/config{,.bak}

vi /etc/selinux/config

在文件中修改

SELINUX=disabled

- 备份 SSH 配置文件,优化 SSH 的连接速度。

cp /etc/ssh/sshd_config{,.bak}

vi /etc/ssh/sshd_config

找到

UseDNS no,去掉前面的#号注释找到

GSSAPIAuthentication no这一行的yes,把yes改成no改完重启sshd

systemctl restart sshd

优化yum源。首先确保虚拟机连接上光驱。

把光盘文件配置为本地源,方便安装软件。前面有#为命令注释,无需输入。

#解挂目录/mnt

umount /mnt

#进入源目录

cd /etc/yum.repos.d/

#把原有源备份到test目录下。

mkdir test -p

mv *.repo test

#配置本地源

echo '[local]

name=local

baseurl=file:///mnt

gpgcheck=0'>local.repo

#挂载光盘内容到/mnt目录下

mount /dev/cdrom /mnt

#清理源缓存

yum makecache

#正常清理源缓存以后,会看到以下结果提示

#Determining fastest mirrors

#Metadata Cache Created

- 执行以下命令,每次启动系统自动挂载光盘内容到

/mnt目录下。

echo 'mount /dev/cdrom /mnt' >>/etc/rc.local

chmod +x /etc/rc.d/rc.local

- 关闭图形化networkmanager,以后统一用network来管理

systemctl stop NetworkManager.service

systemctl disable NetworkManager.service

- 安装 tab 补全

yum install -y bash-completion.noarch

- 安装常用的命令

yum install -y net-tools vim lrzsz wget tree screen lsof tcpdump chrony

上传 JDK 安装包

jdk-8u231-linux-x64.tar.gz到/opt目录下。解压安装JDK

cd /opt

tar -xvf jdk-8u231-linux-x64.tar.gz

mv jdk1.8.0_231 jdk8

- 设置 JDK 相关的环境变量,并运行。

cp /etc/profile /etc/profile.bak

echo "export JAVA_HOME=/opt/jdk8

export CLASSPATH=\$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:.

export PATH=\$JAVA_HOME/bin:\$PATH" >>/etc/profile

source /etc/profile

- 测试 JDK 是否正常安装,正常安装的运行以下命令以后可以返回 JDK 的版本。

java -version

- 修改 hosts,在配置文件末尾加入3个节点配置。注意替换为你的学号。

cp /etc/hosts{,.bak}

echo "10.0.0.71 nodea+你的学号后4位

10.0.0.72 nodeb+你的学号后4位

10.0.0.73 nodec+你的学号后4位">> /etc/hosts

- 安装和设置chrony。打开时间同步配置文件,在文件最后增加以下代码,保存退出。

vim /etc/chrony.conf

server 10.0.0.71 iburst

- 重启时间同步服务

systemctl restart chronyd

- 上传 Hadoop 安装包

hadoop-2.7.3.tar.gz到/opt目录并解压。

cd /opt

tar -xvf hadoop-2.7.3.tar.gz

- 修改 hadoop 存放目录,创建一个 tmp 目录用于存储HDFS文件内容。

mv hadoop-2.7.3 hadoop

mkdir /opt/hadoop/tmp

- 设置/opt/hadoop的拥有者

chown hadoop:wheel -R /opt/hadoop

- 设置 Hadoop 的环境变量。

echo "export HADOOP_HOME=/opt/hadoop

export PATH=\$HADOOP_HOME/bin:\$HADOOP_HOME/sbin:\$PATH:.

">>/etc/profile

- 删除 Hadoop 下cmd后缀的脚本,这些脚本仅能在 Windows 下运行。

rm /opt/hadoop/sbin/*.cmd -f